No meio do caos informacional de hoje, uma nova ameaça cresce silenciosa, elegante — e perigosa. Imagens falsas, criadas por inteligência artificial, estão se espalhando com velocidade e verossimilhança assustadoras. E sim: a maioria de nós não saberia dizer a diferença.

Este artigo é inspirado no TED Talk do especialista em forense digital Hany Farid, que ajuda jornalistas, tribunais e governos a detectar fraudes visuais. Mas suas lições são valiosas para todos — porque estamos, todos os dias, imersos na guerra da realidade contra a manipulação digital.

A Nova Era da Mentira Visual

Manipular imagens não é novidade. Mas a IA generativa mudou tudo. Com ela, qualquer pessoa pode criar, em segundos, qualquer imagem de qualquer coisa — mesmo que nunca tenha existido.

E não estamos falando apenas de memes ou arte experimental. A tecnologia já está sendo usada para:

- Criar nudes falsos para extorsão

- Falsificar vídeos médicos promovendo curas falsas

- Infiltrar reuniões corporativas com deepfakes realistas

- Enganar públicos inteiros com notícias visuais fabricadas

Segundo Farid, até 50% das imagens que vemos online podem ser falsas. E os casos não são mais pontuais: acontecem todos os dias.

Como a IA Gera Imagens “Reais”

Diferente de uma câmera, que captura luz refletida de um mundo físico, a IA funciona assim:

- Decompõe bilhões de imagens reais em puro ruído (pixels aleatórios)

- Aprende a converter esse ruído em algo visualmente coerente com o texto digitado

O resultado imita uma imagem verdadeira, mas não nasce de luz, lente ou física — nasce de estatísticas. É convincente, mas não autêntico.

3 Sinais Visuais de Que Você Está Vendo uma Imagem Falsa

Mesmo sem ser especialista, você pode aprender a identificar padrões de falsificação. Eis os principais sinais:

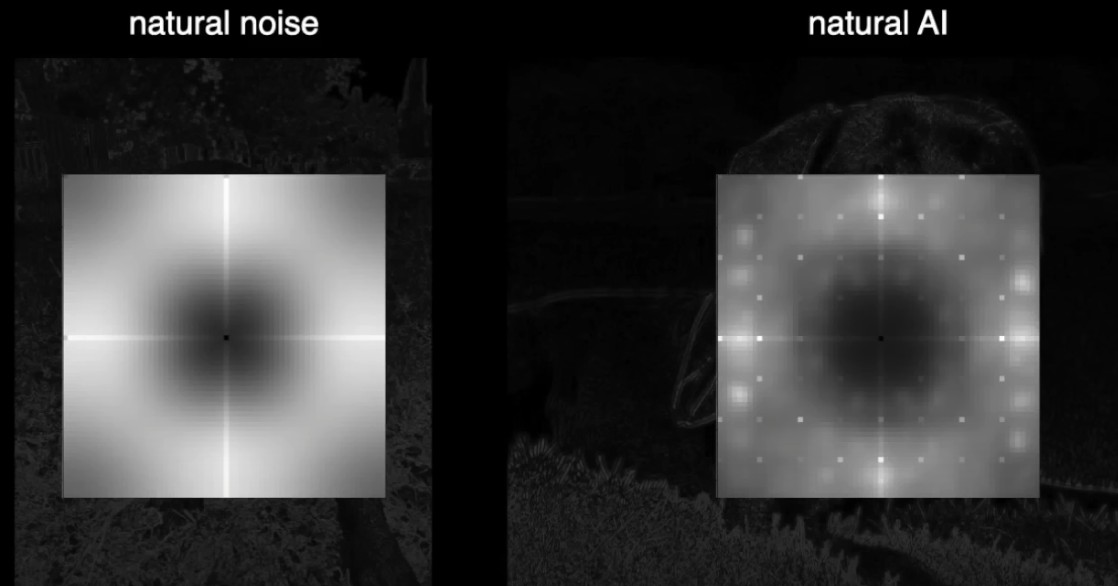

1. Ruído Irreal

Imagens reais contêm um tipo específico de “ruído”, gerado pelo sensor da câmera. A IA, por outro lado, cria padrões artificiais. Especialistas conseguem visualizar esses ruídos — e muitas vezes encontram formas estreladas ou simétricas demais, que não existem em sensores fotográficos reais.

2. Perspectiva Errada

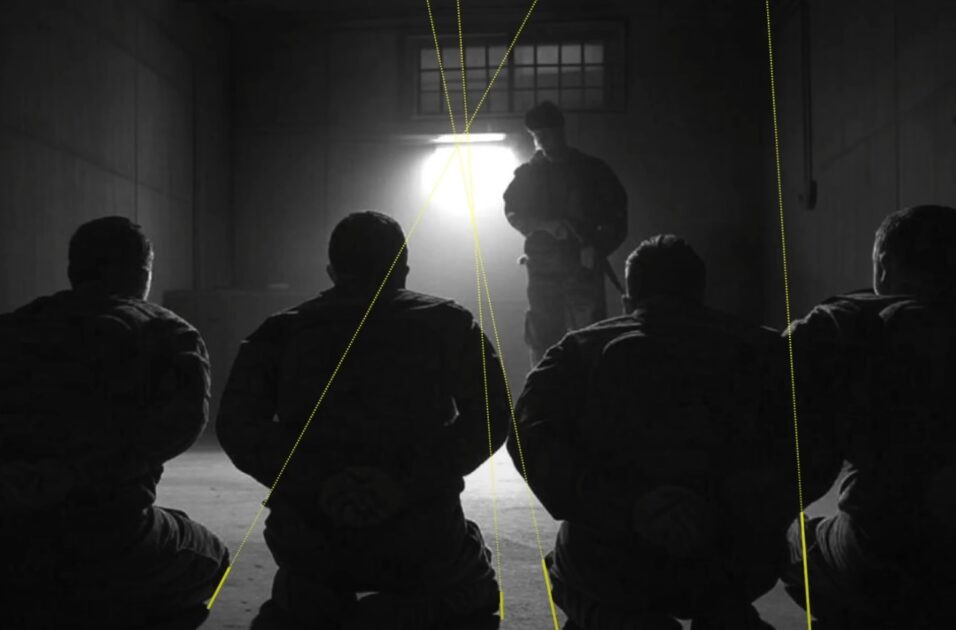

No mundo real, linhas paralelas (como trilhos de trem) convergem num ponto de fuga. A IA costuma errar nisso, criando cenas visualmente agradáveis, mas fisicamente impossíveis. Se a geometria da imagem parecer estranha — talvez ela seja mesmo.

3. Sombras Incoerentes

A luz tem regras: uma sombra deve apontar para a fonte que a gera. Em muitas imagens criadas por IA, as sombras não fazem sentido. Os traços não convergem, os ângulos são aleatórios. É um sintoma claro de que a cena foi gerada sem entender o mundo real.

Também Vale Observar os Sinais Mais Visíveis

Apesar das análises forenses mais avançadas, como as apresentadas por Farid, existem indícios simples e acessíveis que ainda podem ajudar a identificar uma imagem gerada por IA — especialmente quando a tecnologia falha em detalhes.

Aqui estão alguns deles:

- Rostos e corpos simétricos demais, com expressões congeladas e pele excessivamente lisa

- Manchas, borrões e distorções incomuns na imagem, especialmente nas bordas

- Olhos, orelhas e dentes com formas estranhas ou iluminação incoerente

- Cabelos com textura artificial, muitas vezes lisos demais, como pintura digital

- Textos distorcidos ou ilegíveis ao fundo (placas, letreiros, embalagens)

- Fundo borrado de forma exagerada, sem profundidade real

- Contornos mal definidos, como membros com cortes retos, ou objetos fundidos à pele

Esses “defeitos” ainda aparecem, sobretudo em imagens feitas com modelos menos sofisticados. Eles não substituem os sinais estruturais mais avançados — mas servem como alerta inicial.

Ferramentas Online Que Podem Ajudar

Além do olhar treinado, existem recursos gratuitos que ajudam a investigar uma imagem suspeita:

- FotoForensics: mostra metadados e mapas de erro para analisar manipulações

- Busca reversa no Google Imagens ou no TinEye: para ver se a imagem já circulou antes, ou se foi tirada de contexto

O Que Você Pode Fazer (Mesmo Sem Ser Especialista)

Hany Farid oferece quatro atitudes práticas que qualquer pessoa pode adotar:

1. Use Ferramentas de Verificação

Softwares de análise forense e IA já estão sendo usados por jornalistas e instituições. Muitos estão se tornando públicos. Não é necessário ser técnico — só saber que essas ferramentas existem já é um passo.

2. Procure Credenciais de Conteúdo

Está sendo criado um padrão internacional chamado Content Credentials, que autentica imagens desde o momento da captura. Será uma “assinatura digital” que mostra se uma imagem é real ou gerada — ou se passou por edições.

3. Questione as Redes Sociais

As redes são projetadas para engajamento, não para informar. Como Farid diz:

“As redes sociais são junk food visual. Não são uma fonte confiável de notícias.”

Se puder, evite usá-las como fonte principal de informação. Ou, no mínimo, mantenha senso crítico.

Ao compartilhar algo falso — mesmo sem saber — você se torna parte do problema. Respire. Verifique. Valorize o trabalho de jornalistas sérios e checadores de fatos. Eles estão tentando manter o chão firme em um mundo cada vez mais escorregadio.

4. Pense Antes de Compartilhar

A IA já está moldando o que vemos. E, cada vez mais, o que vemos não aconteceu. Isso torna o olhar crítico — o seu olhar — mais importante do que nunca.

Hoje, ver não é crer – é investigar.